@ sandroronca.it

Note biografiche

Posta elettronica

Collegamenti

Piccola InformaticoBiografia

Di una cosa sono certo: le biografie, se sei uno qualsiasi, non interessano granchè.

D'altra parte presentarsi al visitatore è una doverosa forma di cortesia che ogni buon ospite non manca di praticare.

Per quanto mi riguarda, quella buona usanza poteva benissimo risolversi in tre righe, ma ho pensato di proporre una cosa diversa e mi auguro più interessante.

Così, col pretesto delle note biografiche, racconto come ho vissuto e com'erano quegli 'anni formidabili' in cui nacque l'informatica distribuita e prese forma un nuovo modo di comunicare e di accedere alla conoscenza.

Avevamo allora la percezione di vivere uno di quei momenti nei quali la Storia imprime al flusso degli eventi repentine accelerazioni imponendo rapidi mutamenti culturali e sociali. Nuove idee e tecnologie si affermavano ed evolvevano così velocemente da sembrare quasi inafferrabili. Un clima frizzante e dinamico, un nuovo Zeitgeist, annunciava l'incipiente era dell' Information and Communication Technology .

E, come si dice in questi casi, nulla sarebbe mai più stato come prima...

Prologo

Mi sono laureato in Fisica, indirizzo nucleare, presso l'Università di Padova nel giugno 1978 e un anno dopo sono entrato nel mondo della scuola. Dopo la laurea ho iniziato a interessarmi di Informatica, dato che all'Università ebbi solamente un'infarinatura di Fortran. Fortunatamente, infatti, qualche docente illuminato aveva capito che almeno i rudimenti del calcolo automatico un aspirante fisico doveva pur possederli. Il centro di calcolo universitario era off limits per gli studenti. D'altra parte allora la programmazione era di tipo batch: si scrivevano i programmi, si perforavano le schede e si consegnava il pacchetto all'amministratore del centro, il quale mandava in esecuzione i programmi quand'era possibile, rispettando varie priorità. Dopo qualche giorno consegnava gli stampati con i risultati. Se c'era un errore, e quasi sempre c'era, bisognava corregge

rlo, cambiare la o le

schede e ripetere tutta la procedura. Figuriamoci

rlo, cambiare la o le

schede e ripetere tutta la procedura. Figuriamoci  se

ci fossero anche

stati gli studenti tra i piedi.

se

ci fossero anche

stati gli studenti tra i piedi.Inizio: i favolosi anni 80

Ho iniziato, dunque, come molti della mia generazione, programmando il leggendario "Commodore 64", che veniva in quel periodo commercializzato in Italia.

Quel '64' che compariva nel nome, stava esattamente per 64 KB ( 64 x 8 x 1024 = 524288 Bit) di memoria RAM, nemmeno tutta disponibile, essendo in parte occupata dal sistema operativo.

Oggi, per capirci, la capacità di una RAM si misura, come ordine di grandezza, in GB (1 GigaByte = 109 byte o più correttamente 10243 = 230 byte).

Il costo era spropositato. Nel dicembre 1982 pagai il C-64 1.200.000 lire ( circa 1850 € attuali, considerando la svalutazione).

Tuttavia con quei pochi e costosi kilobyte facevamo miracoli, almeno per quel tempo: giochi, applicazioni, programmi, complessi e super-ottimizzati, non potendo sprecare inutilmente nemmeno un bit di memoria.

In quegli anni di grande entusiasmo per la nuova tecnologia tenni alcuni 'pionieristici' corsi di informatica per il personale della scuola. Sto parlando dell'inizio degli anni '80 del secolo scorso, e l'informatica a scuola era veramente cosa da pionieri.

L'elaboratore

elettronico appariva ai più una specie

di scatola magica.

Quasi la

stessa sensazione che un po' d'anni prima provai mettendo le mani, in

"Laboratorio di Fisica 1", su una delle prime calcolatrici

elettroniche in circolazione, l'HP-45,

saldamente inchiavardata alla parete data la preziosità (395 $, nel

1974, 250000

lire, equivalenti a 385 € attuali).

L'elaboratore

elettronico appariva ai più una specie

di scatola magica.

Quasi la

stessa sensazione che un po' d'anni prima provai mettendo le mani, in

"Laboratorio di Fisica 1", su una delle prime calcolatrici

elettroniche in circolazione, l'HP-45,

saldamente inchiavardata alla parete data la preziosità (395 $, nel

1974, 250000

lire, equivalenti a 385 € attuali). I calcoli si eseguivano nella efficiente, ma del tutto innaturale, notazione polacca inversa (RPN). Ad esempio per eseguire 5 x 3 = , si doveva battere la sequenza:

,

al che il display dava il risultato, 15 (non esisteva il tasto =). Si

può provare, cliccando sull'immagine dell'HP-45, con

una simulazione (però della progenitrice HP-35) di Neil

Fraser,

realizzata per HP Museum.

,

al che il display dava il risultato, 15 (non esisteva il tasto =). Si

può provare, cliccando sull'immagine dell'HP-45, con

una simulazione (però della progenitrice HP-35) di Neil

Fraser,

realizzata per HP Museum.Successivamente, mentre collaboravo con una delle prime associazioni di professori (che con incredibile fantasia battezzammo "Informatica & Didattica") convinti della necessità di introdurre l'informatica nella scuola, ho avuto a che fare con l'Olivetti M20 (uno dei pochi personal di quel periodo dotato di grafica ad 'alta' risoluzione e istruzioni per gestirla: a quel tempo Olivetti era all'avanguardia nella ricerca e sviluppo in ambito personal computing), poi con PC IBM (il peggiore di tutti, credo) e quindi con il buon M24 Olivetti.

Stavo allora lavorando, con un collega e amico, ad un programma per la risoluzione dei circuiti elettrici: si costruiva il circuito, utilizzando simboli grafici per i componenti (nodi, conduttori, generatori, resistenza, induttanza, condensatore). Il programma in gwBasic ne riconosceva la topologia ed eseguiva il calcolo di correnti e tensioni. Fu il primo progetto di una certa complessità che affrontammo e che ci permise di imparare un sacco di cose sulla programmazione e i suoi trucchi.

Fu poi la volta del potente Apple Macintosh Plus dotato di uno straordinario sistema operativo a finestre (poi largamente scopiazzato da altri) con il quale si interagiva, oltre che con la tastiera, attraverso un rivoluzionario dispositivo di puntamento: il mouse.

Pascal, l'evoluzione

Si cominciava a parlare di programmazione strutturata e di Pascal, pensando di introdurlo nella scuola proprio per le sue caratteristiche di rigorosità, di tipizzazione forte dei dati (che vanno preventivamente dichiarati e non è possibile passare da un tipo all'altro con una semplice assegnazione, come ad esempio in Basic), di modularità grazie all'uso delle procedure.

Era un altro mondo rispetto al Basic: dalla "programmazione spaghetti", infarcita di goto e di variabili create in qualsiasi momento, all'ordine svizzero imposto da Niklaus Wirth.

Non parliamo poi della velocità. Difficile forse capire oggi cosa significava disporre di un buon compilatore. Ora la potenza di calcolo di cui disponiamo è tale da rendere abbastanza accettabile, almeno per usi normali, anche le prestazioni di un programma interpretato, anche se un ritardo di qualche secondo nella risposta ci può far giudicare come lento o molto lento il programma. Allora l'attesa poteva essere anche di alcuni minuti!

Proprio in quel periodo la Borland metteva sul mercato, a partire dal 1983, un velocissimo complilatore per MS/DOS, a prezzo contenuto: il Turbo Pascal.

Il successo fu enorme: rapidamente divenne il compilatore più popolare in assoluto e fu adottato in molte strutture formative universitarie per insegnare la programmazione strutturata.

Nella versione 5.5 (1989) Borland introduceva anche elementi di programmazione orientata agli oggetti. I programmi andavano pensati non più come pura sequenza di istruzioni, ma come oggetti interagenti tra loro.

Gli oggetti sono concretizzazioni di Classi, sono cioè istanze di una classe, possiedono proprietà (i dati dell'oggetto) e capacità di agire ( i metodi dell'oggetto).

La Classe è una struttura di dati astratta che definisce le proprietà generali (i dati) di ogni oggetto che le appartiene e ciò che ognuno di essi può fare (i metodi). Esempio: la classe Automobile definisce il concetto di automobile (cosa ci fa riconoscere che ciò che abbiamo davanti è un'automobile?) , "Fiat 500" e "Ferrari F430" sono concretizzazioni, istanze di Automobile.

Tutto ciò era decisamente affascinante anche se un po' difficile da capire per chi era abituato a programmare alla vecchia maniera. Il manualetto

Nel frattempo l'hardware si evolveva: dall'intel 80286 della prima metà degli '80, all'innovativo 80386, equipaggiato con il primo processore Intel a 32 bit, che mi costò un occhio della testa, anche perchè lo volli di marca (Intercomp x386) e completo di coprocessore matematico 80387, richiesto quest'ultimo da applicazioni particolarmente impegnative dal punto di vista dell'elaborazione (ad esempio Autocad).

Un progetto impegnativo

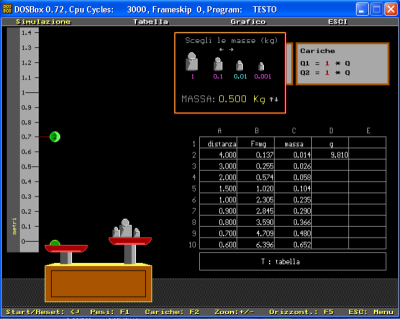

Dopo aver acquisito buona padronanza del Pascal, mi lanciai in un progetto ambizioso: creare una serie di simulazioni di Fisica che rendessero più agevole l'apprendimento dell'elettromagnetismo.

Dovevo immaginare simulazioni didatticamente efficaci e con buone possibilità di interazione. Quel che c'era in giro non era un granchè: poca interattività e orrenda grafica CGA a 320 x 200 punti, 4 colori, mentre con le nuove schede EGA e VGA si poteva finalmente lavorare alla risoluzione di 640 x 480, 16 colori.

Decisi di partire dalla legge di Coulomb: pensai di simulare una bilancia (1) a due piatti

su

uno dei quali vi era una carica elettrica, mentre

un'altra carica poteva essere avvicinata o allontanata. Un

regolo permetteva di misurare le distanze. Modificando

il valore dei pesi posti sull'altro piatto si doveva

equilibrare la

bilancia ricavando così l'intensità della forza elettrostatica

a varie

distanze e per diversi valori delle cariche.

su

uno dei quali vi era una carica elettrica, mentre

un'altra carica poteva essere avvicinata o allontanata. Un

regolo permetteva di misurare le distanze. Modificando

il valore dei pesi posti sull'altro piatto si doveva

equilibrare la

bilancia ricavando così l'intensità della forza elettrostatica

a varie

distanze e per diversi valori delle cariche. Dovevo realizzare tutto da zero: la grafica, il motore fisico, necessario per rendere verosimili i movimenti dei piatti e attendibili i risultati, l'animazione. Volevo una simulazione sufficientemente realistica e quindi era necessario implementare correttamente le soluzioni delle equazioni del moto, per la quali utilizzai il metodo di Eulero. C'era poi il problema dell'elaborazione dei dati.

L'idea centrale era che lo studente, decisa la strategia da adottare (quali parametri far variare e come) e ricavata una serie di dati, si ingegnasse, attraverso l'elaborazione di questi e una successiva rappresentazione grafica, a scoprire la legge di Coulomb.

Pensai quindi di integrare un foglio di calcolo, in stile Visicalc o Lotus123, ma la cosa mi sembrava troppo complicata e l'idea francamente un po' troppo audace per le mie possibilità. Però, se vi fossi riuscito, avrei ottenuto l'importante risultato di aver creato un ambiente didattico autosufficiente: simulazione ed elaborazione senza mai uscire dal programma. Una bella sfida! Decisi di provarci, mettendo anche all'opera qualcuno dei concetti di programmazione orientata agli oggetti, che stavo allora studiando. Creai così la Classe 'cella' con dati e metodi. Era poi necessario realizzare la tabella con la massima modularità, in modo da poter riutilizzare il software nelle simulazioni successive, senza ulteriori modifiche.

Le celle potevano accettare testo, valori numerici e formule di calcolo diretto o tra i contenuti delle celle. In vista di futuri sviluppi, avevo implementato alcune funzioni: elevamento a potenza, radice quadrata, funzioni trigonometriche (sin, cos,arctan), logaritmo naturale ed esponenziale. Ne uscì una cosa piuttosto primitiva, ma ampiamente sufficiente per lo scopo.

Era la volta della rappresentazione grafica. Creare procedure in grado di rappresentare graficamente funzioni date non era una cosa particolarmente difficile. Tuttavia era didatticamente importante che lo studente scrivesse direttamente la forma della funzione matematica, senza avere a disposizione oggetti predefiniti. Per questo motivo dovevano essere rappresentabili virtualmente tutte le funzioni polinomiali, oltre a quelle trigonometriche, al logaritmo e all'esponenziale. Esse dovevano essere inserite attraverso un campo di testo, il che rendeva necessaria la realizzazione di un parser a più livelli, che fosse in grado di analizzare un ingresso, ad esempio, del tipo f(x)=1/(x^3 - 3*x^2+1). Era poi necessario 'saltare' i punti singolari del dominio per evitare il famigerato "Division by zero Error", e trovare un ragionevole compromesso tra qualità della rappresentazione e tempo di esecuzione (i primi tentativi erano alquanto disperanti da questo punto di vista). Francamente furono queste le cose che trovai più complicate. Lavorai duramente e alla fine ebbi la mia bella simulazione funzionante. Devo dire che funzionava pure bene.

Ora

si trattava di capire cosa farne di tutto quel lavoro. Realizzai un

dimostrativo e lo inviai ad alcune case editrici, che, pur apprezzando,

risposero negativamente (forse anche per precedenti infruttuosi

tentativi). Una sola,

l'editrice La Scuola di Brescia, invece della

consueta

risposta

scritta, mi fece chiamare da un funzionario, il quale

mi

manifestò il dispiacere di non poter pubblicare un lavoro

simile, data la politica contingente della casa editrice. Avrebbero

comunque voluto utilizzare le mie competenze proponendomi di

scrivere alcuni articoli

per una

loro prestigiosa rivista, 'Nuova

Secondaria', cosa che poi feci.

Ora

si trattava di capire cosa farne di tutto quel lavoro. Realizzai un

dimostrativo e lo inviai ad alcune case editrici, che, pur apprezzando,

risposero negativamente (forse anche per precedenti infruttuosi

tentativi). Una sola,

l'editrice La Scuola di Brescia, invece della

consueta

risposta

scritta, mi fece chiamare da un funzionario, il quale

mi

manifestò il dispiacere di non poter pubblicare un lavoro

simile, data la politica contingente della casa editrice. Avrebbero

comunque voluto utilizzare le mie competenze proponendomi di

scrivere alcuni articoli

per una

loro prestigiosa rivista, 'Nuova

Secondaria', cosa che poi feci.Leggendo un famoso mensile di informatica del tempo, MCmicrocomputer, trovai un annuncio con il quale una software house di Bologna, la Simulmondo srl, allora nota produttrice di video games, cercava collaborazioni per altri progetti, anche di software didattico.

Mandai il dimostrativo e una descrizione dell'idea. Fui convocato a Bologna per un colloquio da cui nacque un progetto che prevedeva la pubblicazione di due volumi Fisica 2 e Fisica 3 sull'elettromagnetismo (già esisteva Fisica1). Mi impegnai a fondo seguendo le stesse linee guida. Le simulazioni dovevano però essere integrate da un testo ed una serie si esercitazioni. Così mi inventai un testo su tre livelli collegati da 'parole sensibili' (oggi li chiamerei link o collegamenti) che si scorrevano con i tasti cursore (niente mouse ancora) accedendo ai diversi livelli testuali. Senza saperlo (non ero ancora informato di ciò che stava succedendo al CERN di Ginevra e degli studi precedenti) mi ero costruito una specie di elementare ipertesto. Aggiunsi poi una serie di domande con controllo logico e sintattico delle risposte. Terminai così, nel giro di alcuni mesi, il primo volume che fu pubblicato nel 1992. Iniziai anche il lavoro successivo, che però, per problemi interni a Simulmondo, non fu più terminato.

Per gli appassionati di vecchi software o i curiosi, questi programmi sono disponibili e si possono liberamente scaricare da questo sito, nella sezione 'materiali'.

Intanto un nuovo interesse si profilava all'orizzonte.

Internet

Tra il 1989 e 1991 al CERN Tim Berners Lee e Robert Cailliau svilupparono un sistema ipertestuale per facilitare il reperimento delle informazioni e la collaborazione tra ricercatori, definendone sia il linguaggio di formattazione testual

e (HTML) che

il

protocollo di trasmissione (HTTP). Nel 1991,

il 6 agosto, Tim Berners

Lee pubblicò il primo sito web su Internet. Nel 1993 Il CERN rinunciò

ai diritti di autore rendendo pubblico il world wide web

(www).

e (HTML) che

il

protocollo di trasmissione (HTTP). Nel 1991,

il 6 agosto, Tim Berners

Lee pubblicò il primo sito web su Internet. Nel 1993 Il CERN rinunciò

ai diritti di autore rendendo pubblico il world wide web

(www). L'anno dopo, 1994, furono disponibili anche in Italia i primi servizi di accesso pubblico alla rete Internet.

Nel 1996, armato di un modem da 14,4 kb/s, e di un browser Netscape 2.02, entrai a far parte di quel milione, poco più, poco meno, di internauti italiani. L'emozione non fu poca nel veder apparire sullo schermo pagine provenienti da tutto il pianeta. Ed anche il senso di disorientamento. Come quando, davanti a un territorio sterminato, ci prepariamo al viaggio privi di riferimenti, indicazioni o mappe. La salvezza veniva (viene) dai motori di ricerca. A quel tempo i più gettonati erano Yahoo, che dava i risultati migliori, dal momento che i siti venivano selezionati e catalogati da una redazione di operatori umani, e Alta Vista, che vantava uno dei database più cospicui della rete. Una delle cose che forse oggi potrebbe maggiormente colpire è la velocità con cui venivano acquisite le pagine. Facendo un confronto: l'immagine del commodore 64 in questa pagina pesa circa 60 KB. Ciò significa che viene codificata con 60 x 1024 x 8 = 491520 bit, con il mio modem ci volevano 491520/14400 = 34 secondi, mezzo minuto, per scaricarla. Oggi una connessione ADSL da 1 Mb/s = 1048576 bit/s, consente di scaricare la stessa immagine in 491520/ 1048576 = 0,47 s, mezzo secondo! Questo per avere un'idea dei progressi, ma anche di quanta pazienza ci voleva allora...

La curiosità di capire come tutto ciò potesse funzionare era prepotente. E così ricominciai a studiare, imparai l'html, costruivo pagine che peraltro mi soddisfacevano poco a causa dell'assenza quasi totale di interattività. Scopersi Javascript (conoscevo un po' di Java e di C: vi era una qualche somiglianza sintattica e ciò mi aiutava) entrando così, pian piano, nel mondo dello 'scripting'. Diventai bravino con le pagine web, tanto da poter produrre qualche sito anche a livello professionale. Di fatto, per un periodo mi diedi alla produzione di siti e alla consulenza.

C'erano tante cose da imparare, ma la gran parte delle conoscenze e delle soluzioni ai problemi si trovavano nella rete. Questa era la cosa in un certo senso rivoluzionaria: la rete offriva i mezzi per studiare, capire e parlare di se stessa. Internet diventava poco a poco la più grande fonte di informazioni e di collaborazione. Tanti siti, tante persone mettevano le loro conoscenze e i loro lavori a disposizione di chiunque, senza nulla chiedere in cambio. Straordinario. Mi dispiaceva solo di averlo scoperto tardi (esistevano da tempo in Italia e nel mondo

forme di collaborazione e comunicazione

per via telematica, ad esempio la rete 'Fidonet

' , a partire dal 1986 fino al cosiddetto 'Italian

crackdown' del 1994, e la rete Usenet).

forme di collaborazione e comunicazione

per via telematica, ad esempio la rete 'Fidonet

' , a partire dal 1986 fino al cosiddetto 'Italian

crackdown' del 1994, e la rete Usenet).Mi interessava sempre la possibilità di utilizzare queste nuove risorse per la didattica e quindi organizzai un corso di HTML ed elementi di Javascript per un gruppo di colleghi e qualche studente, che avrebbero poi potuto utilizzare le conoscenze acquisite per scopi didattici.

Nel frattempo, la necessità di capire il funzionamento di Internet mi stava portando verso lo studio delle reti di calcolatori. Si affacciavano all'orizzonte nuovi termini: ethernet, TCP/IP, CSMA/CD, pacchetti, router,ecc.

Lato server, ovvero passare dall'altra parte

Conoscevo ormai parecchie cose: riuscivo a progettare pagine web, sapevo caricarle su un server e avevo anche un'idea di come tutto ciò funzionasse, ma ciò che c'era dall'altra parte del doppino telefonico e che diligentemente rispondeva alle richieste dell'utente (il browser) per ottenere questa o quella pagina, restava vago e nebuloso. L'unico modo per capire fino in fondo come veramente funzionassero le cose era quello di riuscire a metter le mani su un server.

L'occasione mi fu offerta, tra il 1999 e il 2000, da una collaborazione con una storica software house del posto, fondata e gestita dal classico geniaccio, tanto vulcanico, quanto poco organizzato. Da anni lavorava su sistemi Unix, su cui giravano gestionali dedicati che venivano manutenuti anche da remoto attraverso connessioni telefoniche da modem a modem (non ancora via Internet). Unimmo le forze e le rispettive competenze per creare un sistema di commercio elettronico basato su Internet. Dovetti imparare da zero a configurare un server, dappprima sotto Unix (usavamo SCO e Caldera) per poi passare definitivamente a Linux. Fu questo il mio primo approccio con l'open source, con Linux...e con il Perl.

Quest'ultimo è uno dei più ostici linguaggi di scripting lato server con cui abbia avuto a che fare, ma in quel momento era quello che meglio ci consentiva di interfacciare le pagine web (il front-end del sistema), con il potente database relazionale che costituiva il motore dell'applicazione. L'esperienza fu emozionante. Si lavorava gomito a gomito, spesso fino a notte fonda, sostenuti anche dall' entusiasmo del responsabile commerciale (poi divenuto mio grande amico), l'uno programmando il database, l'altro trovando le so

luzioni

Perl necessarie: un problema, una soluzione, un problema, una

soluzione...quasi in tempo reale. Era davvero un rivivere il

clima

degli inizi. Un

po' alla volta vedevamo la creatura prendere forma: tra i primi in

Italia, eravamo riusciti a creare una piattaforma e-commerce,

costruendo

completamente in proprio l'interfaccia web.

luzioni

Perl necessarie: un problema, una soluzione, un problema, una

soluzione...quasi in tempo reale. Era davvero un rivivere il

clima

degli inizi. Un

po' alla volta vedevamo la creatura prendere forma: tra i primi in

Italia, eravamo riusciti a creare una piattaforma e-commerce,

costruendo

completamente in proprio l'interfaccia web. Il bagaglio di esperienze che ne trassi fu notevole, ma sentivo l'esigenza di una sistemazione ed approfondimento delle conoscenze che avevo via via acquisito.

Security manager

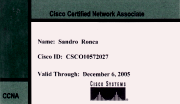

Nel 2000 si valutava che in Italia sarebbero mancate oltre 50000 figure di esperti in tecnologia dell'informazione, capaci di operare nel settore della cosiddetta net economy, dell'economia cioè che fa uso delle risorse di rete. Per limitare il danno che questo 'skill shortage', come veniva definito, avrebbe certamente prodotto, un pool di banche, guidate da Sviluppo Italia, finanziò il progetto "Skillpass". L'obiettivo era di formare gratuitamente e rendere operativi almeno 10000 esperti in un anno. Si dovevano superare delle selezioni iniziali rispondendo ad un questionario on-line e inviando un curriculum. Superai la selezione e scelsi il corso di formazione per Security Manager, che sembrava maggiormente rispondere alla mie esigenze. Le lezioni erano somministrate via Internet e in video-conferenza da Global Knowledge, mentre i laboratori si svolgevano nella sede di Milano. In pratica dovetti seguire un corso introduttivo alle reti di calcolatori, il corso di preparazione alla certificazione Cisco CCNA ( Interconnecting Cisco Networking Devices), uno dei tre corsi previsto per la CCNP (Building Cisco Remote Access Networks, ora: Building Scalable Cisco Internetworks) e un corso specialistico sulla gestione della sicurezza nelle reti Cisco. Lo studio fu alquanto impegnativo, con verifiche intermedie a scadenze precise e inderogabili. Nel 2001 sostenni con successo l'esame finale e finalmente mi ritrovai con competenze sufficienti per gestire una rete di medie dimensioni configurando router, switch e sistemi di autenticazione.

Amministratore di rete a tempo perso (e costo zero)

Vi furono ovviamente ricadute sulla scuola. Insistetti per realizzare una rete interna e alla fine la spuntai: la mia fu una delle prime scuole ad avere un'aula cablata in rete ethernet con accesso condiviso ad Internet via ISDN.

Con l'avvento dell'ADSL, potei realizzare una mia idea. Attivai le procedure per la registrazione di un dominio per la scuola.

Caricai su una vecchia macchina che riuscii faticosamente ad ottenere (le risorse nella scuola sono sempre limitate), una distribuzione Red Hat Linux. Configurai Apache, Snort, Qmail. Installai Rav Antivirus (2) e realizzai un firewall con iptables. Disponevamo così di Web server, servizi di posta elettronica con scansione antivirus e, se pur rudimentale, di un controllo dei contenuti a costo praticamente nullo. Non era il massimo per la sicurezza (tutti i servizi sulla stessa macchina), ma le risorse disponibili non consentivano di più. Per diversi anni poi mi assunsi l'onere aggiuntivo della funzione di amministratore di rete. Dopo il 2003 sostituii qmail e RAV non più disponibile, con Postfix e Clamav. Devo dire, con un certo orgoglio, che, oltre a garantire i servizi per parecchi anni, il sistema resistette a diversi attacchi e in quel periodo non vi fu mai alcuna infezione virale.

Networking Academy

Mi sono sempre chiesto perchè nel mondo della scuola sia così difficile introdurre novità. Immaginavo che vi sarebbe stata una spinta verso l'utilizzo delle nuove tecnologie nella didattica, ma non fu così. Certo si cominciava a usare Internet per cercare informazioni, ma non se ne faceva un uso propriamente didattico. Internet era però interessante anche per la tecnologia in sè e per le opportunità di lavoro che poteva offrire. Con uno dei pochi colleghi curioso dei nuovi mondi della conoscenza cominciai a cercare qualcosa da proporre, nel tentativo di rinnovare gli obsoleti curricula scolastici.

Scoprimmo che Cisco Systems, la multinazionale dei dispositivi di rete, soprattutto router di fascia alta, aveva creato una piattaforma di e-learning ed istituito quelle che venivano chiamate "Networking Academy" (3): ogni istituto scolastico o ente no-profit che lo desiderasse aveva l'opportunità di divenire sede di una Networking Academy, previa formazione e certificazione di almeno due istruttori presso una struttura regionale. Stavamo cercando ansiosamente di vedere se in Italia esistesse qualcosa del genere. Vi era il Cineca a Bologna e poco altro, ma i costi richiesti per la formazione erano troppo elevati. Stavamo per abbandonare quando scoprimmo che proprio la Regione Veneto si era costituita come Cisco Regional Academy e cercava, quasi disperatamente, di istituire quel paio di Networking Academy locali che mancavano per raggiungere il numero minimo necessario alla partenza del progetto. In più, fatto non trascurabile, la formazione sarebbe stata gratuita per le prime dieci Local Academy. Contattammo subito i responsabili e riuscimmo ad inserirci nell'elenco. L'ultimo scoglio fu superato quando convincemmo un sonnacchioso Collegio Docenti ad approvare il progetto, in modo da inserirlo nel piano dell'offerta for

mativa.

mativa.Seguì un altro impegnativo periodo di formazione con verifiche ed esami continui. Conseguimmo infine la certificazione CCNA e quella di istruttore CCAI (Certified Cisco Academy Instructor). Eravamo una delle otto scuole delle regione a divenire Cisco Networking Academy, l'unica della provincia ed iniziammo i nostri corsi di preparazione alla certificazione CCNA per studenti interni ed esterni.

Cercammo di formare altri istruttori, ma purtroppo nessuno dei colleghi aderì all'iniziativa, vuoi perchè i materiali di studio erano in lingua inglese, vuoi perchè l'argomento pareva troppo difficile o semplicemente perchè non ritenuto utile. Anche con gli studenti interni non fu semplice: riuscimmo a istituire alcuni corsi pomeridiani e ad introdurre argomenti di networking nei curricula, ma sempre con notevole difficoltà. La vera soddisfazione veniva però dagli studenti esterni che, motivatissimi, affrontavano dopo il lavoro le lezioni serali e del sabato mattina, provenendo anche da luoghi distanti. La certificazione Cisco era ed è tuttora alquanto ambita. E' unanimemente considerata seria e piuttosto difficile da ottenere. Molti, a seguito dei nostri corsi, la conseguirono e a più d'uno ciò permise di ottenere migliori condizioni di lavoro o addirittura di cambiare (in meglio) tipo di impiego. Nonostante questi riscontri positivi, compresi gli introiti economici che questa attività produceva (provenienti solo dagli esterni, ovviamente, anche se tali costi erano quasi simbolici rispetto a quanto richiedevano le agenzie esterne), la scuola non capì mai la potenzialità offerte da quei progetti. Non se ne fece seriamente promotrice preferendo impegnare energie in altre direzioni, meno orientate all'innovazione e a nuove proposte didattiche.

I corsi per sistemisti

Le competenze acquisite in qualità di istruttore nei corsi Cisco, oltre al background che già possedevo, mi consentirono di progettare due corsi post-diploma, finanziati dal Fondo Sociale Europeo, in collaborazione con un ente di formazione che faceva riferimento all'Associazione degli Industriali. Si trattava di corsi di 500 ore di teoria e 300 di stage presso aziende del settore (tipologia esatta: "formazione post secondaria rivolta a diplomati/laureati in cerca di occupazione") che miravano a formare una figura professionale di "Sistemista ed amministratore di rete" (2003) e di "Sistemista addetto alla sicurezza informatica (2005)". Questi progetti, piuttosto apprezzati, mi diedero notevole soddisfazione ed è motivo di personale orgoglio il fatto che essi permisero a molti giovani di inserirsi con successo nel mondo del lavoro nell'ambito dell'Information Technology.

Epilogo

Al momento di chiudere questa finestra sul passato prossimo del calcolo automatico e dell'Informatica, viene da pensare di come , infine, tutto sembra essere stato una lunga preparazione allo sviluppo della Grande Rete. Con ciò che, nel bene e nel male, ha comportato. Oggi pare quasi ridicolo o quantomeno anacronistico pensare ad un elaboratorre stand alone, isolato, che 'sta da solo' come suggerisce la traduzione letterale dall'inglese. Non possiamo nemmeno più concepire comunicazione e forme collaborative che prescindano dall'esistenza di Internet. Come tutte le cose umane, Internet può essere usata per scopi alti e per altri che certamente lo sono meno. Ma, allo stesso modo in cui nessuno penserebbe di tornare ad usare i lumi ad olio per illuminare le strade, oggi nessuno può ignorare ciò che la Rete rappresenta e offre. Essa ha prodotto in noi cambiamenti irreversibili nel modo di lavorare, comunicare, ottenere informazioni, studiare. Anche se forse proprio la didattica, almeno in Italia, resta uno dei settori che ancora non è riuscito ad avvalersi efficacemente dello strumento e delle sue risorse.

In fin dei conti questo sito nasce anche con la piccola ambizione di portare un contributo e magari di suscitare qualche presa di coscienza sull'argomento.

Ho raccolto e propongo qui una vecchia e storica immagine che, a dispetto della semplicità grafica, rappresenta l'embrione di Internet, la materializzazione di un'idea geniale. Vi sono i primi 4 nodi di Arpanet appartenenti alle quattro università che nel 1969 diedero vita al progetto: l'Università di California Los Angeles (UCLA), Lo Stanford Research Institute (SRI), l' Università di California S.Barbara (UCSB) e l'Università dello Utah . Chi vuole può leggere anche "l'atto di nascita", il primo Request for Comments, RFC 1.

Tutto nacque da lì.

(1) Potrebbe essere un esempio di 'esperimento pensato'. Una bilancia adatta ad una misura di questo tipo sarebbe difficilmente realizzabile: tra l'altro dovrebbe essere del tutto immune ai campi elettromagnetici esterni e generati dalle due cariche.

(2) Prodotto da Gecad, era un ottimo antivirus per mail server, principalmente Linux, che serviva allora quasi 10 milioni di utenti. Acquistata nel 2003 da Microsoft, Gecad ne ha stranamente subito cessato la produzione.

(3) Non essendo ingenui possiamo senz'altro pensare ad una intensa operazione di fidelizzazione da parte di Cisco Systems, attraverso l'offerta di alettanti corsi di studio. Poichè siamo anche pragmatici rileviamo che necessariamente questo tipo di formazione non può essere legato ad una singola marca di dispositivi e che attualmente non esiste qualcosa di seriamente paragonabile all'investimento di Cisco systems in questo settore.

© 2021 Sandro Ronca Note legali e d'uso